Postado em

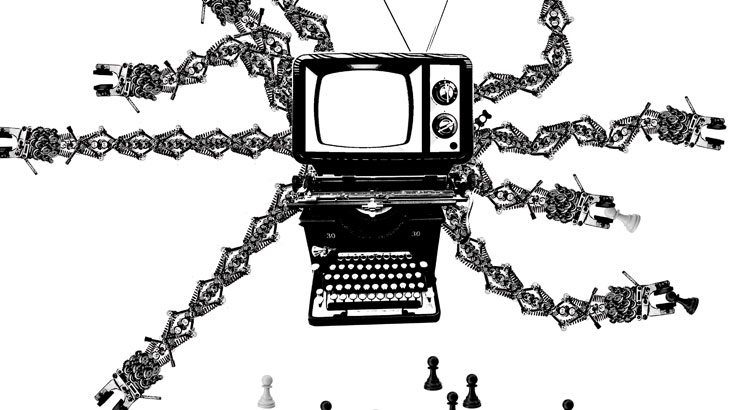

Existe neutralidade nas redes?

A ideia de que toda tecnologia é neutra foi por muitos anos considerada uma verdade. Afinal, graças a ela uma série de facilidades foi incorporada ao cotidiano da sociedade, tais como pesquisar na internet, registrar imagens e vídeos com câmeras digitais e até mesmo “pilotar” carros inteligentes. No entanto, nos últimos anos, vários indícios apontam para a queda desse paradigma. “O debate sobre tecnologias discriminatórias ganha mais corpo nas empresas, universidades e instituições à medida que tecnologias digitais com inteligência artificial, algoritmos e diversos tipos de agentes artificiais ganham espaço nas mais diferentes esferas de nossa vida”, analisa o especialista em monitoramento de mídias sociais e métodos de pesquisa digitais Tarcízio Silva, pesquisador doutorando na Universidade Federal do ABC (UFABC) e na Desvelar Conhecimento e Curadoria. Afinal, que neutralidade há quando em páginas de busca da internet digita-se “mulheres bonitas” e o resultado é uma série de imagens de mulheres com o mesmo estereótipo? Outro exemplo foi evidenciado em 2010 quando câmeras fotográficas indicaram repetidamente que asiáticos estariam de olhos fechados na hora do clique. “Nós precisamos começar a olhar para essas funcionalidades a partir do entendimento de que elas carregam uma visão de mundo, ou seja, os objetivos, as intencionalidades e as subjetividades de quem está criando, pensando e estruturando essas ferramentas”, alertam Silvana Bahia e Larissa Bispo, da Olabi, organização focada em inovação social, tecnologia e diversidade, que faz parte da rede global dos Fablabs, criada no MIT (Instituto de Tecnologia de Massachusetts). Sobre este tema Silva, Bahia e Bispo trazem dados e tecem reflexões.

Racismo algorítmico

Tarcízio Silva

Com certeza você já ouviu falar de inteligência artificial, não é? E sobre aprendizado e treinamento de máquina? Pois bem, antes de apresentar essa ideia, vamos relembrar rapidamente o que é inteligência artificial. Independentemente de sua formação e profissão, possivelmente você já viu algo sobre inteligência artificial em livros ou filmes como Uma Odisséia no Espaço, Eu, Robô ou os mais recentes Her ou Chappie. Mas não se engane, por mais que manchetes sensacionalistas assustem, esse tipo de robô que se revolta contra os humanos está muito longe de existir (se é que existirão um dia). Esse tipo de Inteligência Artificial (IA) que se aproxima do pensamento humano em complexidade e reflexividade seria o exemplo de inteligência artificial geral ou forte.

Mas (ainda bem, diriam alguns) este não é o tipo de inteligência artificial que temos atualmente. A “inteligência artificial restrita” busca realizar um tipo de tarefa em um campo específico de forma bastante eficiente ou rápida. Na área das tecnologias digitais de comunicação temos exemplos como recomendação de conteúdo, transcrição de áudio, jogadores artificiais de xadrez online, processamento de linguagem, reconhecimento facial e outros. Ou seja, se você usa plataformas de mídias sociais ou está lendo esta revista em um smartphone, com certeza teve contato com várias aplicações de inteligência artificial restrita.

E o que o racismo tem a ver com isso? Muita coisa! O debate sobre tecnologias discriminatórias ganha mais corpo nas empresas, universidades e instituições à medida que tecnologias digitais com inteligência artificial, algoritmos e diversos tipos de agentes artificiais ganham espaço nas mais diferentes esferas de nossa vida. Um exemplo histórico que viralizou dez anos atrás, em pleno 2009, foi o caso de um computador da HP com a função de rastreamento facial dos usuários em sua webcam. Mas um problema desumanizador não foi previsto pelos desenvolvedores do sistema: alguns usuários negros não eram “vistos” pela funcionalidade do dispositivo.

O problema está longe de ser erradicado do campo. Nos últimos anos, multiplicaram-se os casos de tecnologias de visão computacional que não veem pessoas negras, não compreendem corretamente suas características (como gênero e idade) ou, ainda, pior: as confundem.

Dupla opacidade

O projeto GenderShades.org, proposto por cientistas da computação afro-americanas, testou recursos de visão computacional da Microsoft, Face++ e IBM. Sozinhas, as cientistas Joy Buolamwini e Timnit Gebru não só identificaram a taxa maior de erros em fotos de pessoas negras, como propuseram um conjunto de dados de treinamento que performou melhor do que os sistemas dessas empresas.

As notas públicas das empresas a casos como esses seguem um padrão recorrente. A tecnologia é culpada e os problemas são apresentados como efeitos indesejados que não poderiam ser previstos. Em parte considerável dos casos algumas medidas são tomadas, mas não se vai ao cerne da questão, que passa pela absurda concentração demográfica e ideológica nas empresas de tecnologia digital e inteligência artificial.

A tecnologia é culpada e os problemas

são apresentados como efeitos indesejados

que não poderiam ser previstos

Ziv Epstein e diversos colaboradores – todos cientistas da computação do MIT (Instituto de Tecnologia de Massachusetts) – identificaram um problema intrigante sobre o lançamento de novos sistemas. Entre 1987 e 2017, mais de sete mil artigos foram publicados na NIPS, principal conferência do mundo sobre redes neurais: um dos ramos da inteligência artificial. Os artigos que propõem novos modelos computacionais são cerca de dez vezes mais comuns do que os artigos que analisam modelos existentes. Ou seja, há uma espécie de abismo entre o interesse do campo em produzir novas tecnologias comparado ao interesse em analisar, criticar e melhorar as tecnologias existentes.

Isso explica, em parte, como tantas tecnologias são lançadas a público com problemas. Mas sem querer subestimar o absurdo de ser “invisibilizado” por tecnologias, os casos vão muito além. Jornalistas, desenvolvedoras e ativistas já documentaram casos de recomendação de conteúdo que hipersexualiza garotas negras, problemas de reconhecimento de emoções, previsões discrepantes sobre reincidência criminal e até sistemas de carros autônomos que têm mais chance de atropelar pessoas negras.

Portanto, é preciso multiplicar os esforços de auditoria algorítmica e crítica social da tecnologia. Mas hoje vemos uma “dupla opacidade”: boa parte das pessoas alega que as tecnologias só podem ser neutras e boa parte das pessoas ignora problemas discriminatórios como racismo e machismo.

E quando o racismo está na tecnologia? O desafio é duplo, e pensar diferentes epistemologias e pontos de vista para quebrar as barreiras do pensamento acrítico sobre tecnologia e sociedade é essencial. Cientistas da computação, sociólogos, engenheiros, artistas e jornalistas possuem capacidades complementares que podem ser postas em movimento para um futuro positivo das inteligências artificiais, naturais e sociais por um mundo melhor.

Tarcízio Silva é especialista em monitoramento de mídias sociais e métodos de pesquisa digitais, estre em Comunicação e Cultura Contemporâneas pela Universidade Federal da Bahia (UFBA), pesquisador doutorando naUniversidade Federal do ABC (UFABC) e na Desvelar Conhecimento e Curadoria.

As tecnologias não são neutras

Silvana Bahia e Larissa Bispo

Mark Zuckerberg, Mike Krieger, Reed Hastings, Travis Kalanick, Garrett Camp, Ben Silbermann, Jack Dorsey, Biz Stone, Noah Glass, Evan Williams. Esses são os nomes dos criadores e fundadores de alguns dos aplicativos mais conhecidos no mundo. O que eles têm em comum? Além de todos terem obtido muito sucesso com suas invenções, a grande maioria – senão todos – são brancos, heterossexuais e do hemisfério norte. Mas talvez você nunca nem tenha ouvido falar deles – os responsáveis por aplicativos que, muito provavelmente, você utilizou hoje mesmo. Em um mundo onde a privacidade está em jogo e relações de poder permeiam os meios digitais, qual a importância de conhecer quem está por trás dessas novas invenções que fazem parte das mudanças que estão transformando o mundo e a maneira de nos relacionarmos?

Os algoritmos estão presentes tanto nos aplicativos como na nossa vida, e nada mais são do que comandos e orientações programados para serem seguidos – em uma explicação rasa, porém de fácil entendimento. Muitas vezes, olhamos para essas tecnologias com um olhar pouco crítico, quase deslocado das aplicações reais. Mas o que está em jogo é: as tecnologias e os aplicativos não são neutros. Nós precisamos começar a olhar para essas funcionalidades a partir do entendimento de que elas carregam uma visão de mundo, ou seja, o olhar, os objetivos, as intencionalidades e as subjetividades de quem está criando, pensando e estruturando essas ferramentas. E é nesse momento que alguns problemas como o racismo algorítmico podem surgir.

Em janeiro de 2010, um aplicativo desenvolvido para as câmeras da Nikon não conseguia diferenciar rostos asiáticos. A Nikon desenvolveu um recurso que avisava se as pessoas estavam com olhos fechados e os olhos de pessoas asiáticas eram alertados. Em 2015, o Google Fotos tagueou rostos de pessoas negras como “gorilas”. Este ano, uma pesquisa da George Institute of Technology revelou que carros autônomos têm mais chances de atropelar pessoas negras. E, é claro, todos os casos que já são comuns nas notícias voltadas à área de tecnologia, de falhas e altas taxas de erros nos sistemas de reconhecimento facial, criados em todo o mundo, em relação a rostos de pessoas negras.

Nos algoritmos que utilizamos todos os dias – seja em aplicativos de streaming, localização, mensagens ou fotos – existem vieses estruturais e sistêmicos. Não é só matemática. Porque quem pensa a tecnologia, quem está nas posições de poder, quem cria e desenvolve os aplicativos mais famosos no mundo ainda é, majoritariamente, o mesmo perfil de pessoas. Em diversos sites e aplicativos de bancos de imagens, basta procurar por “mulher bonita” e ver o que é encontrado. O que acontece nesse tipo de tecnologia é que os aplicativos entendem quais imagens ou palavras-chaves estão sendo mais “pertinentes”. Mas decisões quanto à pertinência podem se tornar um autorreforço. Imagine que uma criança vá fazer um trabalho de escola e precise usar uma imagem desse banco de dados… E ela só encontre mulheres brancas.

Iniciativas como a Algorithmic Justice League [em português, Liga da Justiça do Algoritmo] buscam denunciar e acabar com o racismo implícito em programas de inteligência artificial. Fundadora da iniciativa, Joy Buolamwini percebeu que programas de reconhecimento artificial nem sempre conseguem detectar rostos negros: problema causado pela falta de diversidade das equipes que criam esses programas e das imagens que as máquinas recebem para aprender a “enxergar” esses rostos. “A visão do computador usa inteligência artificial para fazer o reconhecimento facial. Você cria uma série de imagens com exemplos de rostos. No entanto, se essas séries não são diversas o suficiente, qualquer rosto que desvie da ‘norma’ será difícil de reconhecer”, disse Joy Buolamwini em uma Ted Talk.

Problemas como o racismo algorítmico

podem acontecer quando temos aplicativos

com algoritmos enviesados, ou seja, com vieses de cor,

gênero, raça, orientação sexual

Nos bastidores

Democratizar o acesso às tecnologias não é sobre ampliar o consumo. E essa discussão precisa ser colocada a partir da problematização da falta de diversidade nos times. No caso das mulheres negras no Brasil, esse cenário é tão invisibilizado que faltam inclusive dados precisos para medir sua atuação. De acordo com o Instituto Nacional de Estudos e Pesquisas Educacionais Anísio Teixeira (Inep), dos 1.683 engenheiros da computação formados em 2010, apenas 161, ou 9,5%, eram mulheres. No mesmo ano, apenas 14,8% dos 7.339 formados em ciências da computação eram programadoras.

Dados da pesquisa Quem Coda o Brasil, de 2019, realizada pela PretaLab – iniciativa de inclusão de mulheres negras na tecnologia – e pela Thoughtworks (consultoria global de software) revelam que em 21% das equipes de tecnologia do país não há sequer uma mulher, enquanto em 32,7% dos casos não há nenhuma pessoa negra. Para reverter o quadro, a PretaLab lançou uma plataforma digital que une profissionais negras a empresas em busca de mão de obra qualificada.

Falar sobre diversidade dentro da cena tecnológica é cada vez mais importante ao olharmos os quadros das equipes que compõem os times nas empresas. E é dentro desse cenário que problemas como o racismo algorítmico podem acontecer, quando temos aplicativos com algoritmos enviesados, ou seja, com vieses de cor, gênero, raça, orientação sexual. É preciso conhecer quem está por trás das tecnologias que já estão no nosso dia a dia, já estão mudando nossa forma de experimentar o mundo. Enquanto não houver diversidade nesse processo, enquanto pessoas negras, por exemplo, não estiverem pensando tecnologia e inovação, e se não existirem ações para que elas de fato façam parte das mudanças e transformações tecnológicas, nós vamos perder totalmente nosso poder de integração no mundo. Nós não vamos fazer parte do futuro e do que está sendo feito.

Silvana Bahia é codiretora do Olabi, organização focada em inovação social, tecnologia e diversidade pela qual está à frente da PretaLab, iniciativa que estimula mulheres negras nas tecnologias e inovação. Pesquisadora do Grupo de Pesquisa em Políticas e Economia da Informação e da Comunicação do Programa de Pós-Graduação em Comunicação da Universidade Federal do Rio de Janeiro (UFRJ).

Larissa Bispo faz parte da equipe do Olabi, no qual cuida da comunicação e organiza ações da PretaLab. É jornalista, mestranda na Faculdade de Educação da UFRJ.